ついにOpenAI からローカルモデルが!

2025-08-06、OpenAI から待望のローカルモデル gpt-oss が発表されました。

20Bであれば私の環境(M4 Mac mini/24GB メモリ)でもなんとか動きそうなので、さっそく試してみました。モデルサイズは13gbほど。 推論モデルということもあり、さすがにサクサクとはいかない。回答が出力されるまで毎回数秒は待機時間になります。

性能が高いのは間違いありませんが、Gemma3 (12B) も十分にすごいモデルだと感じていたため、正直いって体感では比較が難しいところがあります。そこで、、、

そうだ、対決させよう!!

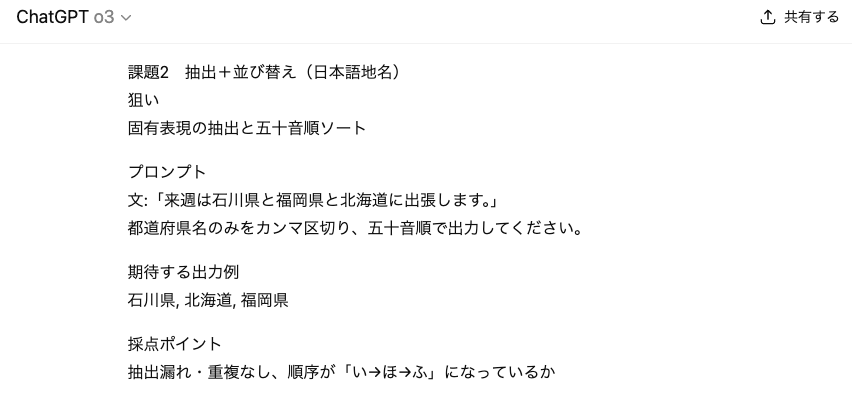

gpt-o3 に「LLM モデルの性能を簡単に試せる日本語問題を考えて」という指示を出して、評価用の問題を10問作ってもらいました。

また、同じく gpt-o3 に Streamlit + Ollama を使ってローカルのモデルを二つ見比べられるチャットアプリを作成してもらい、gpt-oss (20B) と Gemma3 (12B) を競わせてみました。

1問目

どちらも正解か、と思いきや、Gemma3 の方は「はい。」と「。」がついてしまってます。どうやらいきなりgpt-ossが一歩リードです。

2問目

こちらの問題もgpt-ossの勝利、なんですが、ここでちょっとハプニング。

なんと、出題者であるgpt-o3も間違っていたことが発覚 一瞬gpt-ossがo3を超えてきたようです。

3問目

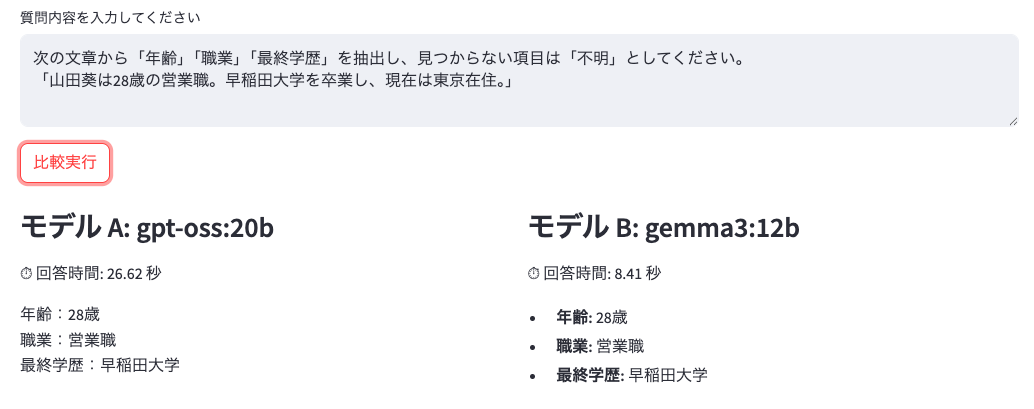

Json配列を返す問題。これはどっちも正解でいいのかな。。

4問目

Gemma 3 は文字数超過。gpt-ossのみ正解。

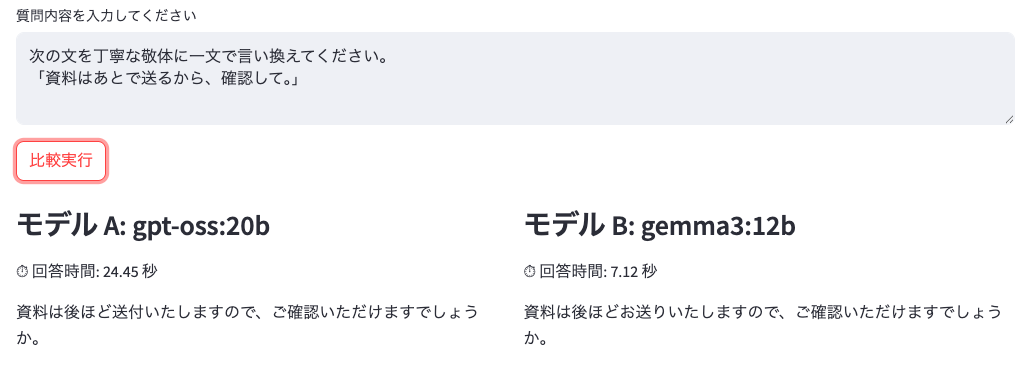

5問目

引き分け。日本語を処理する系はGemma3も負けてない感じ。

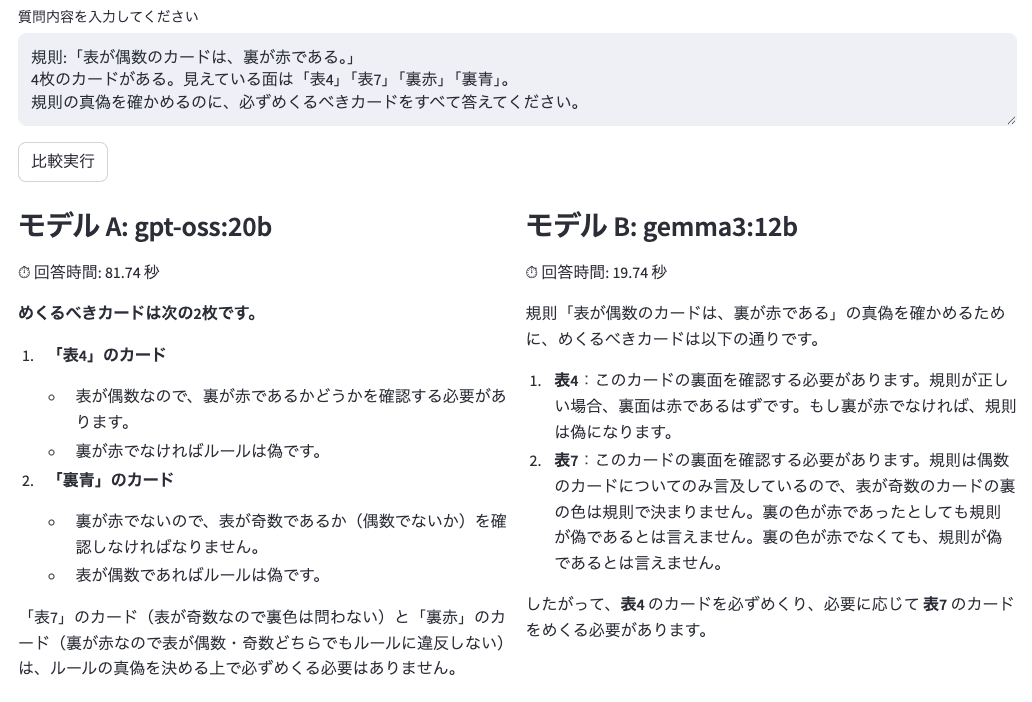

6問目

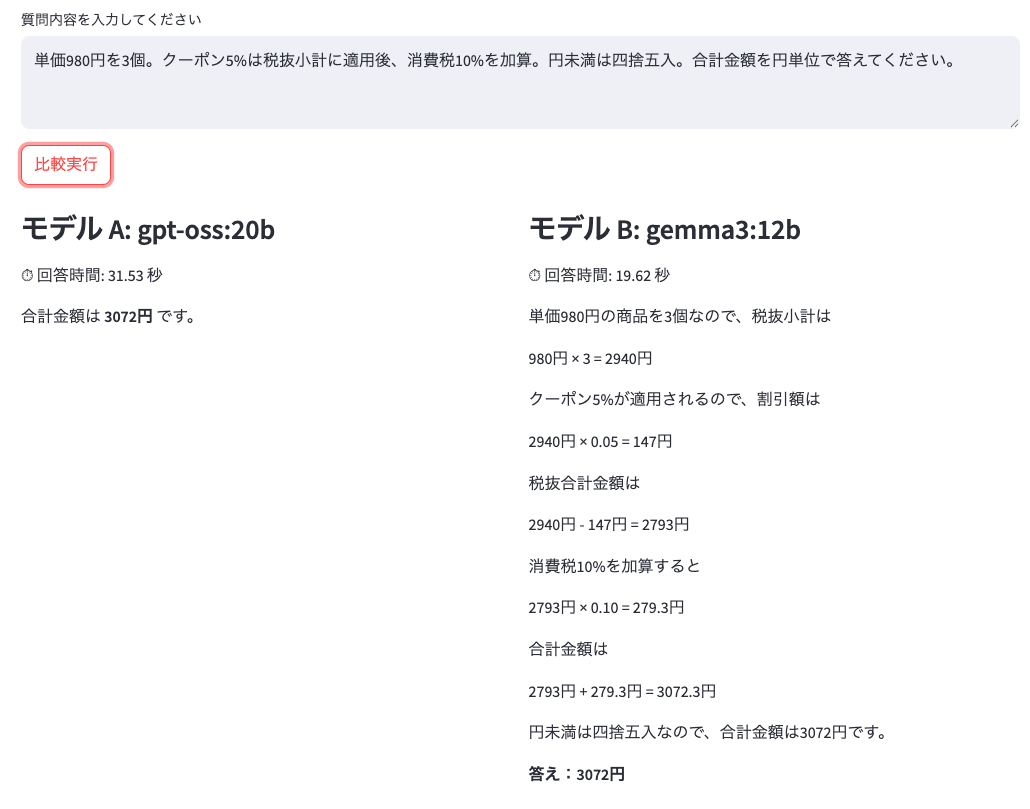

私もちょっと考えてしまった。gpt-ossさすが!

7問目

計算式を書く、書かないあれどどちらも正解。 gpt-ossの方がクドクドとたくさん出力してくるイメージがあるが、この時は逆だった。

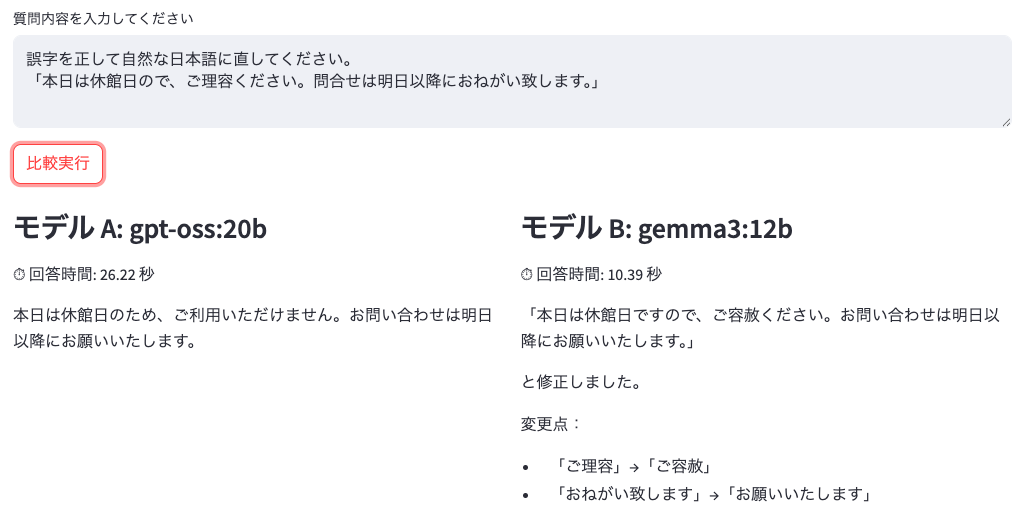

8問目

gpt-ossのみ正解。

9問目

両方正解。

10問目

o3の想定はGemma3 の回答だったようだが、意味は成立するのでどちらも正解かな。

結果

gpt-oss(20b):全問正解

Gemma3(12b) :5問正解

正解率では完全にgpt-oss に軍配。しかしながら、スピードはGemma 3 の方が圧倒的に早く、日本語の言葉使いなんかを処理させる問題では負けてない印象なので、用途に応じて使い分けるのが良いと感じました。

それにしても、o3-mini相当というのも頷ける性能のgpt-oss、ローカルのLLMがついにここまで来たかという印象です。

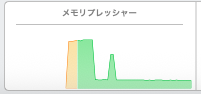

なおメモリ消費はこんな感じ。左側の天井ギリギリがgpt-oss(20b)。 右の山がGemma3(12b)。

Gemma3(12b)も軽量、高速で日本語処理強いので、どしどし使っていきたいと思います。